Op 20 maart – in de Open Education Week, alweer een tijdje geleden – was ik aanwezig bij een Themamiddag over Bibliotheken en Open en Online onderwijs van SURFnet in samenwerking met de SHB en UKB. Daar werden o.a. de eerste resultaten van een verkenning naar de rol die bibliotheken voor zichzelf zien bij open en online onderwijs gepresenteerd. Deze verkenning werd in opdracht van Surf uitgevoerd door dr. Karianne Vermaas (WAU?!). Het rapport is verder aangevuld met de resultaten van de discussie tijdens de bijeenkomst, en op 19 mei 2015 gepresenteerd: De rol van de bibliotheek in open en online onderwijs: een verkenning.

Voor de verkenning heeft Vermaas ca. 30 Hoger Onderwijs-instellingen bevraagd. Daarbij stuitte zij op veel verwarring over de definitie van ‘open en online onderwijs’. Veel verwarring in de definitie. Want wat is eigenlijk Open? Dat het gratis is? Dat je het kunt volgen wanneer je wilt? Maar veel MOOCs – toch het voorbeeld bij uitstek van open en online onderwijs – hebben een vaste begin- en einddatum. Gaat het dan om vrije toegankelijkheid? Maar wederom bij MOOCs heb je vaak een account nodig om deel te nemen. Dat account kan dan wel weer iedereen aanmaken, er zijn geen ingangseisen. Maar is dat vrij, en open?

In de inventarisatie is gekozen voor de definitie dat het materiaal gepubliceerd met een open licentie, zodat hergebruik en aanpassing binnen een andere context mogelijk wordt. Een ietwat bijzondere keus naar mijn mening.

Open en online onderwijs staat in ieder geval bij de meeste instellingen nog in de kinderschoenen en bibliotheken oriënteren zich nog op hun rol. Deze hangt tevens af van de positie die zij in de organisatie innemen. Bij sommige instellingen zit de bibliotheek dicht op het onderwijs, bij andere staat zij er verder van weg.

Als meer traditionele rollen bij Open en online onderwijs worden advies over auteursrechten en licenties, opslag en ontsluiting van materiaal, en het bijbrengen van informatievaardigheden genoemd. Het eerstgenoemde is feitelijk al een vrij moderne rol, aangezien deze direct gekoppeld is aan het ‘digitale tijdperk’. De informatievaardighedenrol kan verschillende vormen aannemen, zoals het aanbieden van eigen open cursusmateriaal van de bibliotheek, maar ook het ondersteunen van faculteiten bij het aanbieden en vinden van open leermateriaal.

Andere rollen die in de inventarisatie ter sprake kwamen zijn content-creatie (ondersteuning bij het maken van onderwijsmateriaal, zoals video’s), content-curatie (selecteren en ordenen van online beschikbaar onderwijsmateriaal, in het verlengde van de klassieke taak van de bibliotheek) en het stimuleren en aanjagen van open en online onderwijs. Ook biedt de bibliotheek bij sommige instellingen een experimenteerruimte: een soort ICTO- of innovatielab met ‘open’ pc’s waarop docenten en studenten alles kunnen uitproberen wat (nog) niet centraal wordt ondersteund. Voorbeelden daarvan zijn EdLab Universiteit Maastricht, Digital Learning Lab Hogeschool Rotterdam, Explora Innovatielab Avans. Bij deze instellingen zit de bibliotheek dicht op het onderwijs. In Leiden is de ICTO-ondersteuning facultair georganiseerd en ontbeert daarom een centrale plek waar alle expertise bij elkaar komt. Wellicht kan de UBL een dergelijke ruimte bieden door de handen met de ICTO-ondersteuners, het ICLON en het ISSC ineen te slaan?

Over opslag van onderwijsmateriaal werd in de presentatie aanvankelijk vrij snel heen gegaan, maar hier werd later tijdens de bijeenkomst op teruggekomen. Waar dit in het gedrukte tijdperk over boekenplanken ging, gaat het nu om servers en repositories. Online beschikbaar materiaal is een randvoorwaarde voor de onderwijstrend van ‘flipped classroom’, die beoogt dat studenten de stof op eigen gelegenheid tot zich nemen zodat de contacturen kunnen worden gereserveerd voor interactie (en niet voor uitleg).

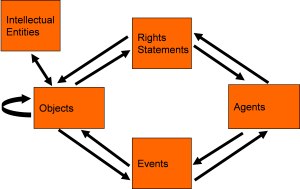

De UBL is tot nu toe terughoudend wat betreft de opslag van leermaterialen. Er hangen aan dit materiaal dan ook enkele ingewikkelde aspecten: De rechten van het gebruikte leermateriaal liggen vaak niet bij de eigen instelling, en het materiaal kan vele vormen aannemen (teksten, afbeeldingen, powerpoints, video, audio, interactief materiaal, etc.).

De UBL heeft nu 2 repositories, die eind 2015 in een gezamenlijke infrastructuur moeten zijn ondergebracht: Het Leiden Repository in DSpace met ‘Leidse’ wetenschappelijke publicaties en scripties (alleen zelfgeproduceerd materiaal dus), en Digital Special Collections in Digitool (veelal rechtenvrij). Het online beschikbaarstellen van (verzamelingen van) materiaal van anderen zonder de rechten goed te regelen is tricky, en dat geldt ook in een besloten systeem.

In de praktijk slaan docenten het onderwijsmateriaal bij een cursus (dat niet online of niet voor een Leidse doelgroep beschikbaar is) direct in Blackboard op, desnoods eigenhandig gedigitaliseerd. Maar dit is – ook voor zelf geproduceerd materiaal – geen geschikte opslagplek. Items zijn niet vindbaar en herbruikbaar door collega-docenten, en bij gebruik in meerdere cursussen (ook van dezelfde docent) moeten deze vaak dubbel worden ingevoerd. Videomateriaal neemt veel serverruimte in beslag, waardoor de licentiekosten van Blackboard (het opslaggedeelte) hoog oplopen. Dit is momenteel een serieus issue, waaraan de nieuwe Leidse streaming video dienst (opvolger van U-Stream) soelaas moet bieden.

Dit project heeft helaas inmiddels een flinke vertraging opgelopen, maar ook als de streaming dienst straks wordt gelanceerd, blijft de vraag wat je er precies in mag opslaan en onder welke voorwaarden. Alleen eigen materiaal? Ook materiaal van anderen, maar dan alleen met toestemming en wellicht besloten? Hoe regel je dat? Inhoudelijk gaat het sowieso om hybride materiaal: leermiddelen (kennisclips en andere educatieve video), (populair-)wetenschappelijke producties (zelf vervaardigde documentaires, presentaties voor vakgenoten of een breed publiek), wervingsmateriaal (PR-video’s), maar ook onderzoeksdata (opnamen van testpersonen, veldwerkopnamen, etc.).

Maar zou je er ook er ook een collectie gedownloade video’s in kunnen opslaan die je wilt ‘veiligstellen’ voor onderzoek, of een op internet gevonden video die jouw onderwijs goed illustreert?

Zo moet er in het kader van de nieuwe videodienst moet over veel zaken nagedacht gaan worden die ook op andere repositories toepasbaar zijn. Wellicht komen we zo tot randvoorwaarden, waaronder in het nieuwe Leidse repository (op termijn) ook leermiddelen ook opgeslagen zouden kunnen worden. Hand in hand!